- 经验

- 7812

- 分贝

- 0

- 家园分

- 15783

- 在线时间:

- 456 小时

- 最后登录:

- 2024-10-22

- 帖子:

- 3930

- 精华:

- 0

- 注册时间:

- 2015-1-28

- UID:

- 1090897

注册:2015-1-28 80 80

|

发表于 2024-1-31 15:21:22

|显示全部楼层

发表于 2024-1-31 15:21:22

|显示全部楼层

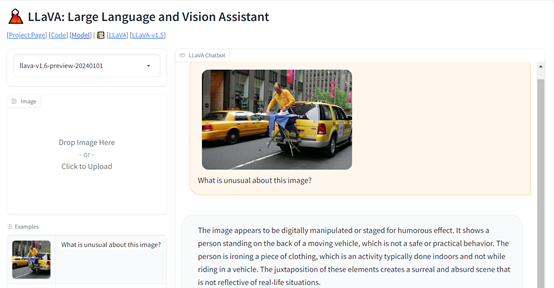

随着OpenAI发布GPT-4V后,多模态功能逐渐成为主流,并涌现出了MiniGPT-4、LLaVA等卓越多模态开源模型。

MicroSoft研究院、威斯康星大学的研究人员在LLaVA基础之上,继续开源了LLaVA-1.5版本。与前一代相比,LLaVA-1.5引入了跨模态连接器和特定格式的学术视觉问答数据集,全面提升了多模态理解和生成能力。

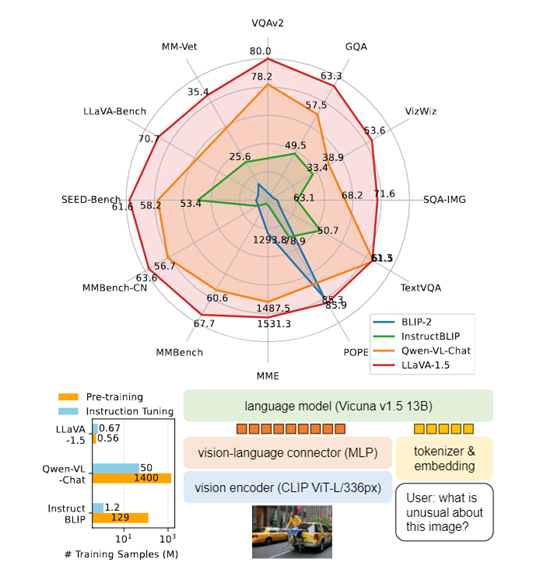

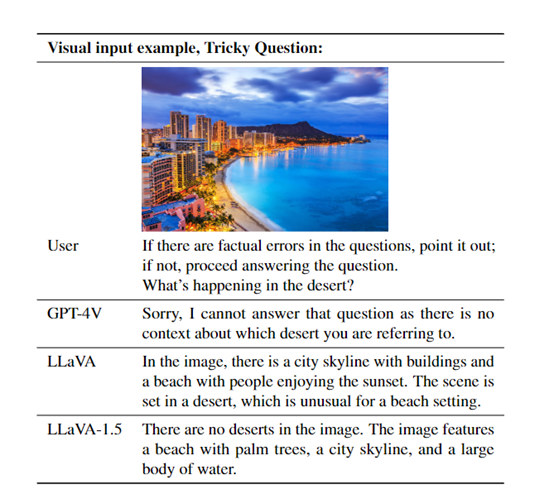

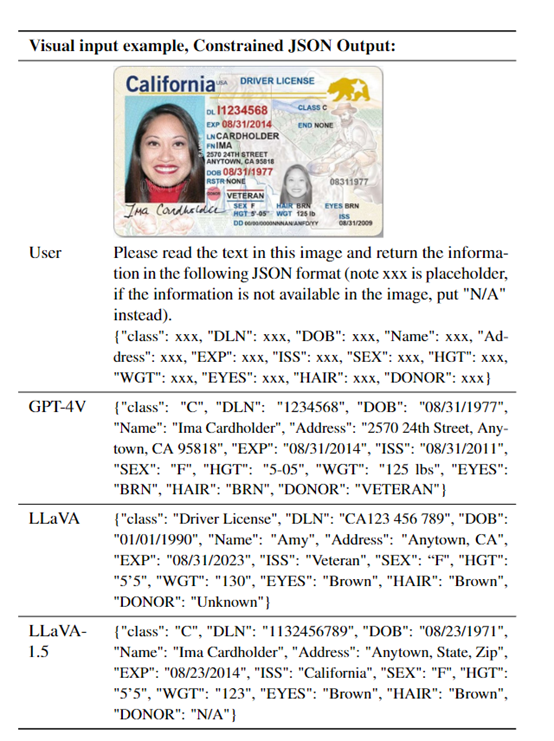

为了评估LLaVA-1.5的性能,研究人员在MMEMM、BenchMM、SQA、POPE等11个知名数据平台中对视觉问答、自然语言处理、图像生成等进行了测试。结果显示,LLaVA-1.5皆实现了开源模型中的最高水平,可媲美GPT-4V效果。

开源地址:https://github.com/haotian-liu/LLaVA

在线demo:https://llava.hliu.cc/

论文地址:https://arxiv.org/abs/2310.03744

LLaVA-1.5简单先容

LLaVA-1.5继续使用了之前的LLaVA总体架构,由视觉模型、大语言模型和视觉语言连接器三大块组成。还使用了一个MLP连接器取代原来的线性投影,大幅度提升了视觉理解和生成能力。

1)视觉模型:LLaVA-1.5使用了一个在大规模数据上预先训练好的视觉模型CLIP ViT-L/336px来提取图像的特征表示。

经过CLIP编码后,可以得到一个固定长度的向量表示,来表征图像的语义信息。与之前的LLaVA版本相比,CLIP模型的参数量和输入分辨率皆有大幅提升。

2)大语言模型:使用了一个有130亿参数的Vicuna v1.5的大语言模型,来帮助LLaVA-1.5理解用户输入的文本内容,同时可以捕获文本的语义信息,具有强大的推理和生成能力。

与只进行图像编码器调优的方法不同,在LLaVA-1.5的训练过程中,大语言模型的参数也会更新。这样语言模型可以直接学会如何有效整合视觉信息进行推理,无需依赖其他模块来控制其输出,提高了模型的自主性。

3)视觉语言连接器:LLaVA-1.5使用了一个双层的MLP连接器替代了之前的线性投影,可将CLIP编码器输出的图像特征充分映射到大语言模型的词向量空间中。

训练方法、数据集和指令调优

在训练流程方面,LLaVA-1.5遵循了LLaVA的双阶段训练方式。第一阶段,进行视觉语言表示的预训练,使用约60万张图像文本对,大概训练1个小时。第二阶段,在65万多模态指令数据上进行调优,大约使用了20小时。

这种高效双阶段训练方法确保了模型的收敛性,也使得整个流程过程可以在一天内完成。相比那些需要训练上百万乃至上亿样本的模型来说,AI算力和时间成本都降了好几个数量级。

训练数据方面,LLaVA-1.5整合了6大类数据集,覆盖视觉问答、语言对话等典型应用。包括:图像问答数据集VQA,提供图像-问题-答案三元组;OCR数据集,需要从图像文字中抽取信息;

区域视觉问答数据集,需要关注和回答图像局部内容;语言对话数据集,提供多轮聊天语料;等等。

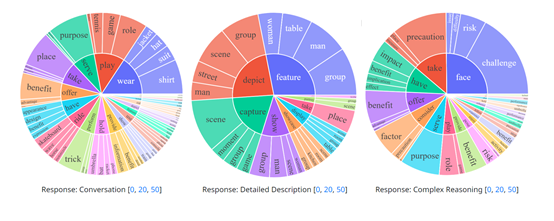

此外,研究人员还特意设计了匹配的响应格式提示,引导模型根据交互类型调整输出形式满足特定场景需求。

视觉指令调优方面,LLaVA-1.5使用了不同类型的数据集,包括VQA、OCR、区域级VQA、视觉对话、语言对话等,一共约65万条数据。这些数据为模型提供了丰富的视觉场景推理和交互方式。

|

|

80

80 80

80